Riflessioni a partire dall’intervento di Donatella Tamagno su “Le misure dell’Open Science”

Quando si parla di scienza aperta, la tentazione di “contarla” è fortissima: quante pubblicazioni open access, quanti dataset FAIR, quante ore di formazione. Ma, ricorda Donatella Tamagno (Scuola Normale Superiore), vale ancora l’ammonimento di Charles Goodhart: quando una misura diventa l’obiettivo, smette di essere una buona misura.

Applicato all’Open Science, questo paradosso è tutt’altro che teorico. Se trasformiamo gli indicatori in target da raggiungere a ogni costo, rischiamo comportamenti opportunistici, distorsione delle priorità, effetti collaterali sull’ecosistema della ricerca. L’intervento di Tamagno all’evento “Abbracciare il Futuro. Fare Scienza Aperta oggi – 2ª edizione, 2025” si muove esattamente su questo crinale: come misurare l’Open Science senza ridurla a una check-list di adempimenti, ma facendone uno strumento di governo, apprendimento e responsabilità.

Perché misuriamo l’Open Science (e che cosa rischiamo)

L’Open Science è ormai, almeno sulla carta, il nuovo standard della politica scientifica europea. La Raccomandazione UNESCO del 2021 la lega esplicitamente a valori di qualità e integrità, beneficio collettivo, equità e giustizia, diversità e inclusione.

Misurare l’Open Science serve a diversi scopi:

- accountability: mostrare a ministeri, finanziatori e cittadini che le politiche adottate producono cambiamenti reali;

- governo delle istituzioni: pianificare investimenti in infrastrutture, personale, formazione;

- apprendimento collettivo: capire cosa funziona, dove si inceppa la macchina, quali barriere permangono.

Ma la misurazione è utile solo finché non diventa la destinazione. Quando gli indicatori vengono estrapolati dal loro contesto e trasformati in obiettivi rigidi (per esempio, “raggiungere il X% di OA entro il 2027”), la pressione a “fare numero” può:

- spingere verso modelli OA più rapidi ma meno sostenibili (es. ibrido a pagamento);

- incentivare pratiche poco virtuose (depositi frettolosi, metadata minimi, licenze poco chiare);

- lasciare indietro dimensioni non immediatamente quantificabili (equità, diversità, qualità del riuso dei dati).

La prima proposta di Tamagno è quindi metodologica: usare più indicatori, combinare quantitativo e qualitativo, lavorare su orizzonti temporali lunghi, rivedere periodicamente il quadro per evitare che si irrigidisca.

Lo schema di monitoraggio italiano: un’iniziativa dal basso

Il cuore dell’intervento è la presentazione di uno schema di monitoraggio delle attività di Open Science sviluppato in Italia dal basso, da un gruppo di università e centri di ricerca prima ancora che arrivassero strumenti nazionali coordinati.

L’idea nasce dall’assunto che, sebbene l’Italia abbia un Piano Nazionale per la Scienza Aperta dal 2022, a oggi, non esiste ancora un monitoraggio ufficiale pubblicato a livello ministeriale.

Di fronte a questo vuoto, un gruppo di atenei (grandi, medi, piccoli e scuole a ordinamento speciale) avvia un lavoro congiunto per definire un set di indicatori condiviso, sostenibile da compilare e riusabile da qualunque istituzione voglia misurare le proprie pratiche di Open Science.

Il lavoro si appoggia a un Virtual Research Environment (VRE) in D4Science, infrastruttura europea che offre ambienti collaborativi per comunità scientifiche, gestendo dati, flussi di lavoro e strumenti analitici in modo integrato.

All’interno di questo VRE viene costruito lo schema di monitoraggio e lo strumento di raccolta dati (Open Science Observatory_Italia), a cui le istituzioni con partecipazione volontaria, possono iscriversi e contribuire annualmente. Lo schema è pensato in modo estremamente flessibile, perché non tutte le istituzioni possono oggi raccogliere gli stessi dati, e il set è stato testato, corretto e documentato con linee guida ed esempi pratici.

Attualmente 11 atenei hanno già inserito i propri dati nel catalogo dell’Osservatorio (fra cui UNIBO, UNIMI, UNIMIB, UNIPD, UNITN, POLITO, SNS).

Sei aree tematiche per leggere l’Open Science

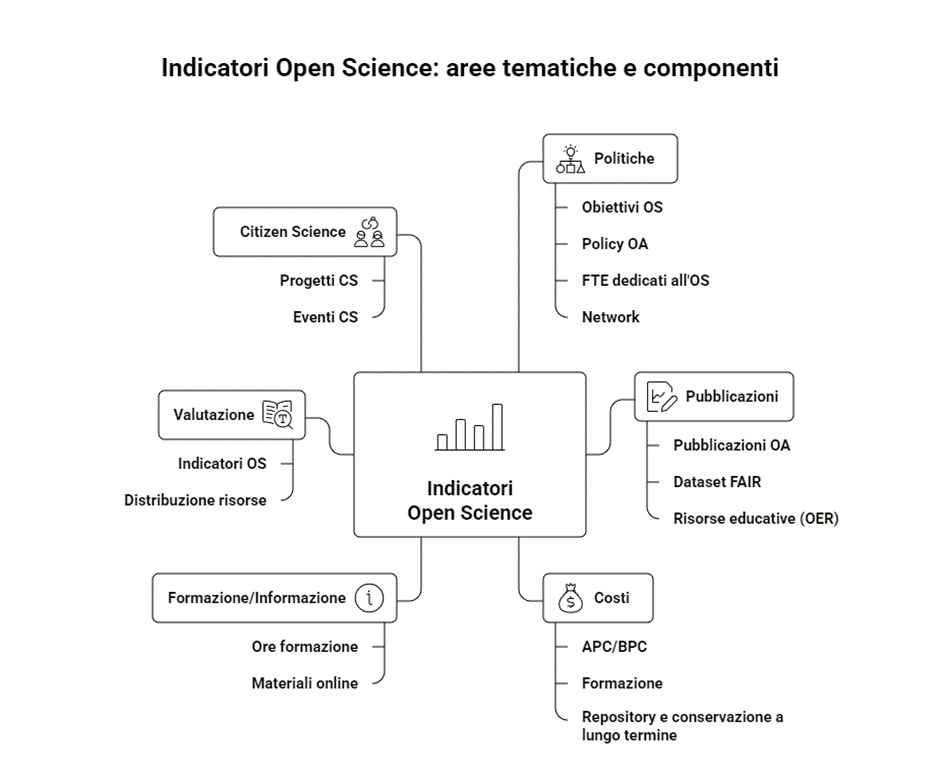

Lo schema attualmente adottato organizza gli indicatori in sei aree tematiche:

- Politiche

- Pubblicazioni

- Costi

- Formazione/Informazione

- Valutazione

- Citizen Science

Per ogni indicatore vengono specificati il tipo di risposta attesa (sì/no, numerica, testuale) ed esempi di compilazione, in modo da aumentare l’omogeneità della rilevazione tra atenei. La raccolta è annuale e i dati sono visualizzati in forma tabellare e, per alcuni indicatori chiave (come la quota di OA o la presenza di obiettivi OS nei piani strategici), anche tramite grafici comparativi.

Un tassello in un mosaico europeo

Il lavoro italiano non nasce dialogando con iniziative nazionali coordinate in altri Paesi europei:

- il French Open Science Monitor, avviato nel 2018 come strumento di governo del Piano nazionale per la scienza aperta;

- il Danish Open Access Indicator, che monitora l’attuazione della strategia OA 2018–2025;

- il National Open Access Monitor irlandese, lanciato nel 2024 per accompagnare l’obiettivo del 100% OA per la ricerca pubblicamente finanziata entro il 2030;

- l’Open Access Monitor Deutschland, focalizzato su pubblicazioni, costi e modelli economici di pubblicazione.

Gli indicatori selezionati dall’iniziativa italiana mostrano ampie sovrapposizioni con questi strumenti, collocandosi in una cornice europea coerente, mantenendo allo stesso tempo una forte attenzione alla sostenibilità della raccolta dati nelle singole istituzioni.

Misuriamo output. Ma dovremmo misurare anche outcome e impatto

La scienza aperta è un concetto in continua evoluzione, ma non basta misurare i suoi output: è necessario considerare anche gli outcome e gli impatti a lungo termine. Questo implica fare una distinzione tra tre aspetti fondamentali della scienza aperta:

- Attività e investimenti: includono le politiche, le infrastrutture, il personale, la formazione e i costi editoriali.

- Output: i risultati immediati della scienza aperta, come il numero di pubblicazioni open access (OA), i dataset disponibili e le risorse educative aperte (OER).

- Outcome: gli effetti a medio termine, come il cambiamento nelle pratiche di ricerca, nelle collaborazioni internazionali, e il miglioramento della riproducibilità.

- Impatto: gli effetti a lungo termine sulla scienza, sulla società e sull’economia.

Oggi, la maggior parte degli sforzi di monitoraggio si concentra principalmente sugli output e sugli investimenti. Misuriamo ad esempio il numero di pubblicazioni OA, la presenza di repository, e la quantità di risorse disponibili secondo i principi dei dati FAIR. Tuttavia, l’analisi degli outcome e dell’ impatto è molto meno strutturata e necessita di maggiore attenzione. Non sappiamo ancora con certezza quanto la scienza aperta abbia effettivamente migliorato la riproducibilità, stimolato nuove collaborazioni, accelerato l’innovazione, favorito il dialogo con i decisori politici, o generato benefici economici e occupazionali.

Per colmare questa lacuna, è utile fare riferimento al progetto europeo PathOS – Open Science Impact Pathways, che ha sviluppato un Open Science Indicator Handbook. Questo strumento ha lo scopo di identificare gli indicatori dell’impatto accademico, sociale ed economico della scienza aperta.

Possibili indicatori di impatto

A partire dalle riflessioni di PathOS e altri framework simili, sono stati individuati una serie di indicatori che potrebbero integrare quelli già adottati in Italia per monitorare l’Open Science. Ecco alcuni esempi:

Impatto accademico:

- Intensità delle collaborazioni: ad esempio, la percentuale di co-autorialità tra diverse istituzioni, Paesi e discipline.

- Diversità: il numero di istituzioni e Paesi coinvolti in output di scienza aperta, nonché la distribuzione per genere e area disciplinare.

- Uso di dati, codice e metodi: si misura quante volte dataset, software e protocolli aperti vengono citati nelle nuove pubblicazioni.

Impatto sociale:

- Adozione da parte dei policy maker: il numero di citazioni di articoli o report open access in documenti di policy, linee guida, e normative.

- Diffusione in ambito educativo: l’inclusione di output di scienza aperta in manuali, corsi universitari, o risorse educative aperte (OER).

- Contributo agli SDG: la percentuale di prodotti di scienza aperta che trattano in modo esplicito gli Obiettivi di Sviluppo Sostenibile.

Impatto economico:

- Collaborazione scienza-industria: la percentuale di brevetti che citano pubblicazioni o dati resi disponibili in open access.

- Innovazione: la creazione di nuovi prodotti, servizi o tecnologie grazie agli output di scienza aperta.

- Lavoro e competenze: la creazione di nuove figure professionali legate all’Open Science, come i data steward o gli esperti in FAIR.

Questi indicatori non sostituiscono i tradizionali indicatori relativi ai volumi di Open Access, ma li completano, avvicinando la misurazione agli obiettivi valoriali stabiliti dalla Raccomandazione UNESCO, che sottolinea l’importanza di un beneficio collettivo, dell’equità e della qualità nella scienza.

Pubblicazioni e dati: che cosa stiamo monitorando e che cosa ci manca

Un’analisi più approfondita sui dataset e sulle pubblicazioni mostra che, mentre oggi siamo in grado di misurare la quantità di prodotti di scienza aperta (per esempio, il numero di pubblicazioni OA e il numero di dataset depositati nei repository FAIR), gli outcome e gli impatti sono ancora in gran parte inesplorati.

Quanto sono davvero riutilizzati i dataset in contesti extra-accademici? E quanti dei risultati pubblicati in Open Access contribuiscono a ridurre i costi, evitare duplicazioni o accelerare risposte a emergenze sanitarie o ambientali? In un contesto in cui la sicurezza della ricerca e la scarsità di risorse rischiano di portare a contromisure restrittive sull’apertura, è fondamentale poter dimostrare, con dati concreti, l’impatto positivo della scienza aperta. Questo, infatti, potrebbe rivelarsi decisivo anche sul piano politico.

La riflessione da avviare in Italia

Se riconosciamo che la misurazione dell’Open Science deve andare oltre il semplice conteggio dei prodotti, è il momento di iniziare una riflessione condivisa su cosa monitorare e su quali parametri utilizzare (output, outcome, impatto). Inoltre, è fondamentale definire con chiarezza i parametri da utilizzare per ridurre ambiguità e incomparabilità e per valorizzare infrastrutture pubbliche e dati aperti (come IRIS, OpenAIRE, OpenAlex, e OpenCitations).

In questo contesto, l’attività condotta dall’Osservatorio italiano rappresenta un laboratorio prezioso. Questo lavoro dimostra che è possibile costruire sistemi di monitoraggio condivisi “dal basso”, senza dover attendere esclusivamente gli indirizzi centrali, e che la misurazione può diventare uno strumento di apprendimento collettivo, e non solo di controllo.

La vera sfida, alla fine, è rimanere fedeli all’idea iniziale: usare le misurazioni per guidare il cambiamento, senza farle diventare l’obiettivo. Nel caso della scienza aperta, questo significa non perdere mai di vista la domanda fondamentale: in che modo ciò che apriamo oggi rende la scienza di domani più equa, robusta e utile per tutti?